你的数据正在被克隆?算法偷走的可不只是时间

限于技术本身的风险性和伦理悖论,克隆技术被严禁应用于人体实验,这些年,“克隆”这个词在公共场域很少被人提及,取而代之的是“人工智能”。但当今时代,对于个体的“数据克隆”却无时无刻不在进行着。我们的饮食习惯、穿衣品味、出行路线、身体健康状况等都正在以数据的形式被各类APP记录在案,算法甚至还能够通过点赞、评论等行为留痕判断并记录下个体的思想情感和性格特征。

每一个人都是行走的数据源,个体在网络上的所有行为都能够被互联网技术解构,再重组成为可识别、可抓取、可利用的数据图谱,从而为商业活动和个性化服务提供指导。毫无疑问,基于人机交互和算法的内容分发、商品推荐,正是构成移动互联网时代大众传播和电子商务的坚实基础。

但是,算法所带来的隐忧,也越来越多地引起公众的关注,人们惊奇地发现自己正在乐此不疲地刷着各类信息资讯,并在不经意间跌入到了信息茧房的陷阱之中;发现自己在私密交谈时被种草的商品如影随形地出现在网购APP的推荐页面里……让渡隐私以获得便利的事情,每天都在发生,算法偷走的,可不只是用户的消费时间。

或许,从悲观的角度来看,算法对个体数据的复刻所带来的争议并不比生物学上的人体克隆争议要小。本期全媒派(ID:quanmeipai)将从算法的偏见、信息“偏食”的代价和个人信息的权属争论等角度展开论述,抛砖引玉,试析大数据时代全面数据化的现实和被算法支配下的个体困局。总之,算法不是洪水猛兽,但它的风险点也值得反复论证、探讨。

算法的偏见是与生俱来的?

2016 年,国内一篇题为《基于面部图像的自动犯罪概率推断》的论文公开发表,该论文通过LR(逻辑回归法)、KNN(k近邻法)、SVM(支持向量机)和CNN(卷积神经网络)四种算法,对 1856 张人脸进行分析并发现罪犯普遍的面目特征。无独有偶, 2017 年,斯坦福大学一个研究团队发表了一篇题为《通过面部图像分析深度神经网络比人类更精准判断性取向》的论文,宣称该AI算法能够通过照片高准确率的识别出同性恋。

上述两项研究引发了巨大的争议,争议的焦点并不在于算法是否能够实现准确的预测,而在于致力于通过预测提供决策指导的算法,是否会增加或强化传统社会里普遍存在的歧视与偏见,比如上述人脸识别技术在识别犯罪潜质方面的不当科研应用便让很多“瞳距偏近、嘴角下扬、人中明显……”的普通人非常尴尬,让其感受到来自于大数据算法的恶意。

“算法以貌取人”的案例还告诉我们,大数据算法中包含着人的经验的投影,不可避免的带有“以偏概全”的风险。这并非是由数据模型的偏差所导致,而是因为在本质上,作为人类观察世界的表征形式之一,算法未超出对人类经验归纳总结的逻辑范畴,即“通过历史数据的训练,形成类的概念(或聚类或分类),然后对新对象进行归类,按类的集合属性,实现对新对象的特征预测”。

从这一角度来讲,算法的偏见是与生俱来的。国内大数据应用领域的专家学者周涛在《数据的偏见》一文中也明确指出,“让我们不安的是,因为系统设计人员带来的初始偏见,有可能随着数据的积累和算法的运转慢慢强化放大。”也就是说,大数据与算法不可能独立于人从而保持客观性,其会在人机交互的过程中从人身上继承偏见。

此外,在现实的应用场景中,数据样本偏差、算法模型设计缺陷、数据解读受人为干扰等因素都会导致或加剧算法的偏见,从而致使某一被大数据算法关照的标签群体受到不公平待遇。

例如,相关研究表明,Google的广告系统在推送工作招聘信息时,男性受到的高收入工作推送频率远高于女性;“查询被逮捕记录”的广告推送更倾向于推送给黑人群体。还有,我们在日常网购中遭遇的“大数据杀熟”无疑也包含着刻意的偏见。

算法让信息“偏食者”钻进茧房

就目前而言,算法在新闻传播上的一个基础型应用是资讯APP的个性化推荐。

人人有自己的关注点和信息圈层,是再正常不过的社会现象,因此信息“偏食者”的出现也不足为奇。在海量的资讯中找到自己偏好的信息,并据此量身定制一份个性化的资讯信息服务,是信息技术进步的表现,也是资讯过载的必然结果。

但是,人们的担忧在于,算法在内容个性化推荐分发方面的极致应用,或正在把信息的私人订制推入美国学者桑斯坦所提出的“茧房”悖论。

信息茧房的争议史几乎也是数字化媒介的发展史,此间,不乏有论者将致力于个性化资讯推荐的算法视为个体乃至整个社会信息“自闭”的罪魁祸首。显然,这种对待算法的敌视观点不够客观、有失公允。因为,作为独立个体的读者对于内容的选择和鉴别始终掌握着更大的主动权,其随时可以通过丰富阅读打破“茧房”禁锢。

不过,不能否认的是,算法的出现,确实让少数缺乏自制力的信息“偏食者”钻进了牛角尖。对于这部分懒惰的、选择用对信息的自主选择权换取便利的网民而言,算法很可能会越俎代庖,由信息适配者的角色僭越为对个人胃口了如指掌的信息投喂者。

在《新媒体用户研究——节点化、媒介化、赛博格化的人》一书中,清华大学新闻与传播学院彭兰教授将“信息茧房”划分为两类:

1、某个平台或应用造成的茧房,即“局部的阅读内容的狭窄”;

2、整体视野与思维上的茧房,即“对社会环境感知的偏见”。

前者可能会对后者形成影响,而后者则会使人们在公共对话时缺乏共同的视角。

而正如彭兰教授所指出,“共同‘视角’的缺乏,意味着人们对一些事实的判断会出现偏差,共识难以形成……也可能会进一步固化人们的某些观点与立场。”从这个角度来讲,算法不仅具有与生俱来的偏见,或从人身上继承偏见,还会真切参与到人的偏见的构建之中,对人与人之间的对话产生影响。

个人信息与隐私的权属争论

数据即财富,除了资讯的个性化推荐,算法大数据还带来了电商的精准营销。而电商的精准营销是建立在对用户数据充分收集、分析、处理的基础之上的,因而其在给人们带来财富和便利的同时,也带来了另一个关乎普通人隐私安全的深层次风险,即无处不在的数字化监视。

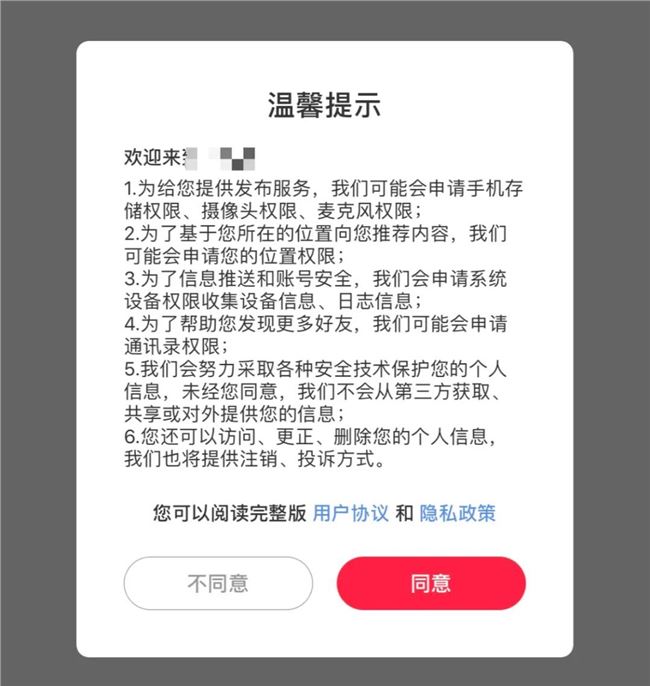

这并非是危言耸听,“APP频繁自启,十分钟访问照片文件 25000 次”的新闻屡见报端,人们对安装一款APP后被频繁要求授权访问通讯录、照相机、文件夹的“用户协议”更是司空见惯。近年来,也不时有网友公开质疑自己私密交谈的某些内容很可能正在被“偷窥”。

图片来源:某APP截图。

被“偷窥”的多数信息的权属边界是明晰的,其与用户在公共平台上留下的数字化痕迹、特征信息有着本质上的区别。

但是,对于个人信息的权属问题依然有诸多疑问,比如所有在公共互联网上可采集到的个体信息都属于公共资源吗?个体在决定停止使用某款APP的服务后,是否有权要求平台方删除所有关于自己的信息记录?如果没有删除,用户能拿平台怎么办呢?

随着信息技术的快速发展,在可以预见的未来,各种传感器将能够随时随地捕捉人的数据,人将会迎来全面的数据化,甚至我们还可以想象,算法大数据或许还能够根据源源不断的传感数据和个体的数字化痕迹对人进行数字化克隆,就像科幻电影里所描述的那样,把个体的“意识”载入到计算机中。

届时,如果在法律上还没有关于个人信息清晰的权属界定,个体有可能会被作为数据“金矿”进行开采、计算。人们或将更加真实的生活在资本的数字化监视下,而互联网对信息保存的复制性、永久性也将使个体更为渺小,这显然是用户不愿意看到的。

不过,个人数据权在法理上的讨论从未停止,有学者认为其作为一种新型基本权利,属于人格权;而有的学者则提出个人数据权已超出一般人格权的范畴,具有显而易见的财产权的属性。

此外,隐私权、被遗忘权、删除权等相关权利也均在具体的法律条文中有所体现,例如:

2012 年欧盟出台的《一般数据保护条例》首次提出“被遗忘权”,规定信息主体有权要求信息控制者删除与其个人相关的资料信息;我国实施的《网络安全法》确认了“删除权”,即个人发现网络运营者违反法律、行政法规的规定或双方约定收集、使用其个人信息的,有权要求网络运营者删除其个人信息。

终归,和互联网一样,算法是一种工具,我们要正视其与生俱来的能量和偏见,在大力挖掘开发其价值的同时,谨防其凌驾于个体权利和社会制度之上。

参考资料:

1.张玉宏,秦志光,肖乐:大数据算法的歧视本质. 自然辩证法研究,2017(5).

2.周涛:数据的偏见. 金融博览,2017(5).

3.彭兰:新媒体用户研究——节点化、媒介化、赛博格化的人. 中国人民大学出版社,2020: 338.