如何打造中国版的“万能AI”GPT-3

GPT-3 支持输入自然语言自动生成公式

本质上,GPT-3 是一个大规模预训练 NLP(自然语言处理) 模型。大规模预训练是指,先用大量没有标注的语料做无监督学习,得到一套模型参数,然后再用少量标注语料精调,最后应用于具体的下游 NLP 任务。这种模式已经诞生了不少成功的 NLP 模型,如 Google 2018 年推出的 Bert,但其通用性上依然不足。直到 GPT-3 推出,让这类预训练模型的通用性上了一个台阶。

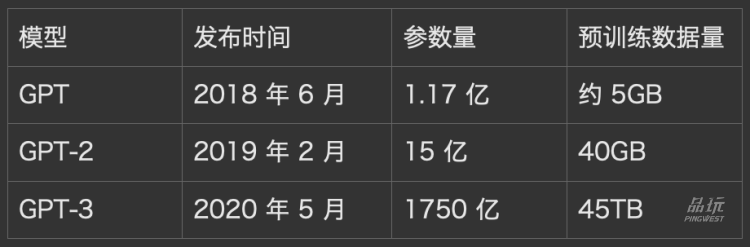

从 GPT 第一代到 GPT-3,其模型层面一直都是基于 Transformer(一种领先的提取语义特征方法)做预训练,没有什么改变,但训练数据量和模型规模十倍、千倍地增长。

2018 年 6 月发布的 GPT 第一代,预训练数据量仅为 5GB。GPT-2 增长为 40GB,GPT-3 更是猛增到 45TB(等于 45000GB)。而模型规模方面,从 GPT 第一代的 1.17 亿参数量,指数增长为 1750 亿。

随着数据量和模型规模的增大,GPT 逐渐舍弃了用少数标注语料精调这一步,完全基于预训练得出的参数,去做下游任务,精确度依然有一定保证。

GPT 所需算力也越来越夸张,初代 GPT 在 8 个 GPU 上训练一个月就行,而 GPT-2 需要在 256 个 Google Cloud TPU v3 上训练(256 美元每小时),训练时长未知。到 GPT-3,预估训练一个模型的费用超过 460 万美元。

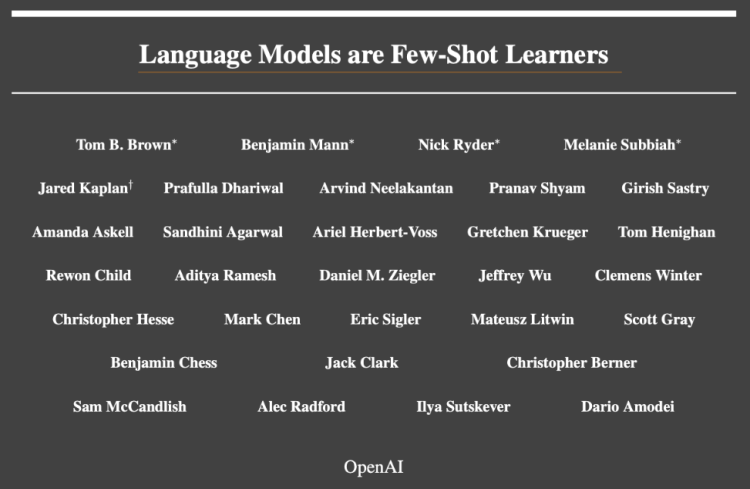

至于人力方面的配置,他表示 GPT 是一个非常综合的大系统工程,涉及到学术、工程、商业等团队之间的大规模协同。一般需要搭建几十人的团队,其中包括科学家、工程师、项目经理等角色。

“我们可以结合数据优化、数据生成等方式来提高训练语料的有效性。初步来看,具体训练语料,主要包括百科问答、新闻资讯、博客电子书类数据及其它泛爬数据,经过数据处理后其规模在 500GB 左右。”李志飞说。

GPT-3 模型参数到达 1750 亿,其背后训练资源的开销非常庞大,预估训练一个模型的费用超过 460 万美元。不过,随着国内外各项研究的推进,预训练模型的训练效率将会不断提升。

“我们可以借鉴其他预训练语言模型的优化经验,在训练语料、网络结构、模型压缩等方面多做工作,预计将模型的单次训练成本降低一个数量级。”李志飞说。

其次,构建 GPT 模型的过程中,将涉及到超算中心和AI算法平台的建设,这些算力和算法平台可以为企业、科研机构、政府提供底层服务,通过开放平台为产业赋能,如智能车载、智慧城市、科技金融等领域。

另外,虽然 GPT 本质是一个关于语言的时序模型,但语言之外的其它时序问题,如经济、股票、交通等行为预测,也有可能成为潜在应用场景。

GPT-4 可能如何演化?

目前的 GPT-3 模型还严重依赖小样本学习机制。虽然 GPT-3 不需要精调,但是在完成具体的 NLP 任务时,还是会把少量和任务相关的实例给模型。在零样本和单样本的任务上,GPT-3 退化比较明显,事实上后面两个任务才是更普遍遇到的问题。

“下一代 GPT 模型需要加强在理论上的泛化能力,以便更好地处理零样本和单样本的任务。”李志飞表示。

“当然,这个反馈也是通过数据来实现的,而不是让GPT真正像人一样去探索物理世界。”李志飞说道,“另外,鉴于 GPT 希望实现完全无监督学习的初衷,这个反馈更多是隐式的和延迟的,而不是显式的和及时的。为了做到这些,需要引入强化学习(re-inforcement learning)之类的机制。”

李志飞还认为,GPT-4 可能引入任务执行能力。现在的 GPT 主要是一个预测和生成的引擎,而不是一个任务的执行器。

比如,你跟GPT说“帮我订一下明天下午三点左右北京去上海的经济舱的机票”,目前GPT也许能理解这句话的意思,但还没有能力自动调取订票网站的 API(应用程序接口)去执行任务。如果不具备这种执行能力,GPT的通用性就很有限,因为每一个任务都需要额外增加代码用以执行理解后的任务。所以,GPT 必须学习怎么直接执行任务。

总体而言,李志飞对 GPT 的未来发展非常乐观:“未来互联网上的很多内容或知识,都会是由类 GPT 模型产生或加工过的。所以某种程度上,GPT的发展代表着语言主权的演进,且它将有潜力成为一种生态系统。”